Identificar los deepfakes, un reto casi imposible: "Ahora mezclan audios reales con trozos generados con IA"

Se puede generar una voz sintética a partir de una grabación de tan solo tres minutos de duración

La Universidad de Granada ha desarrollado un software que permite a los periodistas identificar los deepfakes de audio

La profesora titular de Ingeniería Informática Zoraida Callejas nos explica cómo lo han creado: “Hemos usado el discurso de Navidad del Rey para entrenar un modelo que detecta sus voces clonadas”

Con la aparición de la IA generativa, la posibilidad de clonar la voz de un famoso está al alcance de cualquiera. Esta herramienta ya se usa desde hace un tiempo en el mundo audiovisual para ‘devolver’ a la vida a personas fallecidas. Uno de los primeros casos de uso fue en el documental de Netflix ‘Los diarios de Andy Warhol’ (2022), donde se clona la voz del artista para locutar sus cartas.

Sin embargo, los creadores de deepfake han encontrado una mina de oro en la IA generativa para difundir desinformación sobre políticos y famosos. En la Universidad de Granada han creado una herramienta para detectar cuándo un audio ha sido generado con esta tecnología e intentar luchar contra este uso ilegítimo. La profesora titular de Ingeniería Informática, Zoraida Callejas, confiesa que “cada vez los métodos para generar voces sintéticas son más sofisticados”. Lo que antes se resolvía por pura intuición, ahora no es tan fácil.

MÁS

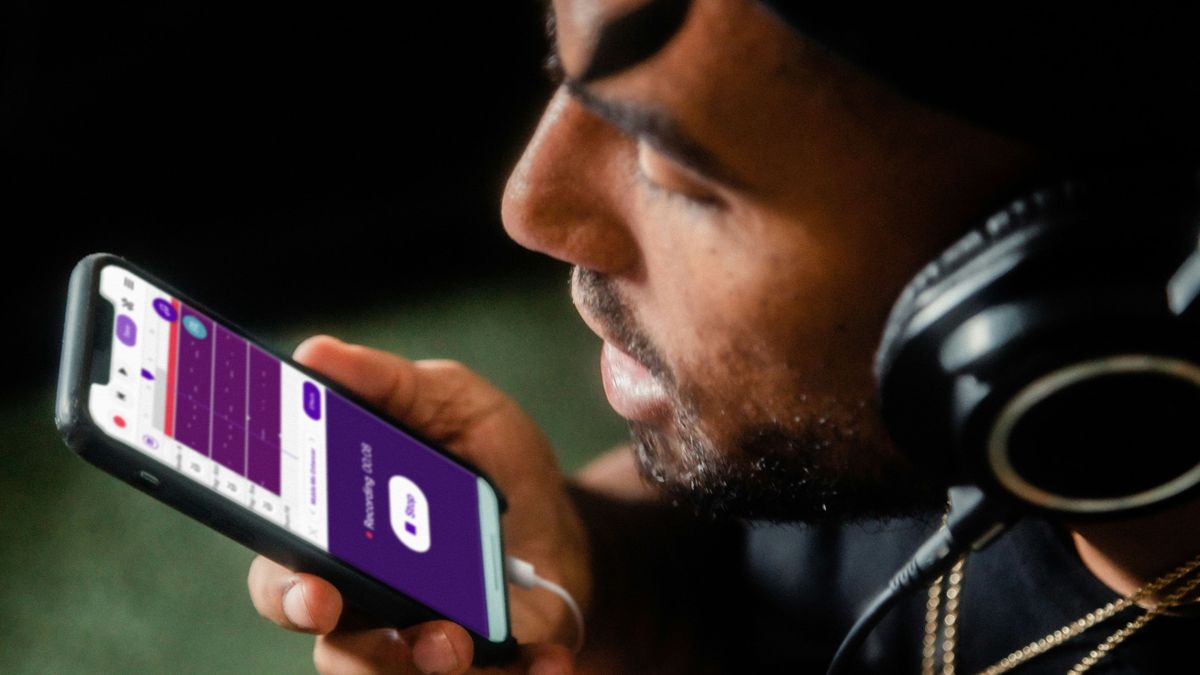

Esta herramienta, creada en colaboración con el proyecto IVERES, permite identificar cuándo un audio ha sido manipulado y también ofrece “el porcentaje de confianza de que la predicción sea correcta”. De esta manera, los periodistas tienen la posibilidad de contrastar las informaciones que les llegan. La tecnología ya la usa Verifica RTVE para comprobar el contenido ‘sospechoso’ que les llega a través de las redes sociales.

Diferentes formas de engañar

El fake puede ser creado con una voz totalmente sintética y luego “se le pasa un texto y lo locuta” o también hay otra forma que es la “conversión de voz”, en la que “una persona se graba a sí misma y el algoritmo le cambia la voz a la de, por ejemplo, el presidente del Gobierno”, afirma Callejas. En el primer caso, se puede clonar una voz a partir de tres minutos de grabación, aunque para que suene real se necesita mucho más contenido.

El problema es que “ahora mezclan grabaciones reales con trozos falsos y esto despista al algoritmo”. Ahí es cuando se complica la detección. La experta afirma que la lucha contra los deepfakes “es una carrera similar a la de los antivirus”, porque cuando logran entrenar al algoritmo, surge una nueva forma de generar audios para la que el software no está preparado.

Los políticos y el Rey tienen su propio detector

Como hay personajes públicos sobre los que se genera mucha desinformación, la universidad también ha creado modelos de detección específicos para ellos. Para los ministros han usado sus intervenciones parlamentarias. En el caso del Rey “lo hemos entrenado con el discurso de Navidad”, explica Callejas, ya que es necesario el audio en buena calidad y también la transcripción para que el algoritmo aprenda a discriminar si es real o falso. De esta forma, la fiabilidad del modelo aumenta considerablemente, al estar entrenado con ejemplos de la misma voz que debe detectar.

Síguenos en nuestro canal de WhatsApp y conoce toda la actualidad al momento.

Suscríbete a las newsletters de Informativos Telecinco y te contamos las noticias en tu mail.